Je größer die Datenmengen desto höher sind die Anforderungen. Es reicht nicht, Daten nur zu haben. Anwendungen (und Anwender) wollen schnell auf die Informationen zugreifen und sie verarbeiten können. Außerdem sollen die Daten verfügbar sein. Immer. Je nach File- oder Storagesystem sorgen RAID-Verbünde für die nötige Ausfallsicherheit. Wie verfügbar und ausfallsicher Daten letztendlich sind, hängt von vielen Faktoren ab. Ein RAID-Controller ist einer dieser Faktoren. Das weit verbreitete SAS und immer beliebtere SSDs machen es dem RAID nicht leichter. Worauf man achten kann und warum, das erklären wir mit diesem Artikel. Für das Verständnis gibt es zunächst ein paar Grundlagen zur Datenverarbeitung und warum viel nicht immer auch viel hilft.

Im Internet ist oft von einer Round-Trip Time (RTT) die Rede. Die gibt es natürlich auch im Rechenzentrum. Die RTT – oder auch Paketumlaufzeit – sagt aus, wie lange es dauert, bis auf eine Frage die Antwort kommt. Je kürzer die RTT ist, desto schneller erhalten wir ein Ergebnis. Will man wirklich die beste Performance, muss man den ganzen Stack kennen – und beherrschen. Das beginnt bei der Anwendung und hört nicht bei der Disk auf. Eine wichtige Rollen im Hardware-Stack spielen Host Bus und entsprechende Adapter (HBA), Prozessoren, Kommunikationswege und -Protokolle, Arbeits- und andere Speicher sowie zusätzlich benötigtes Equipment – z. B. RAID-Controller.

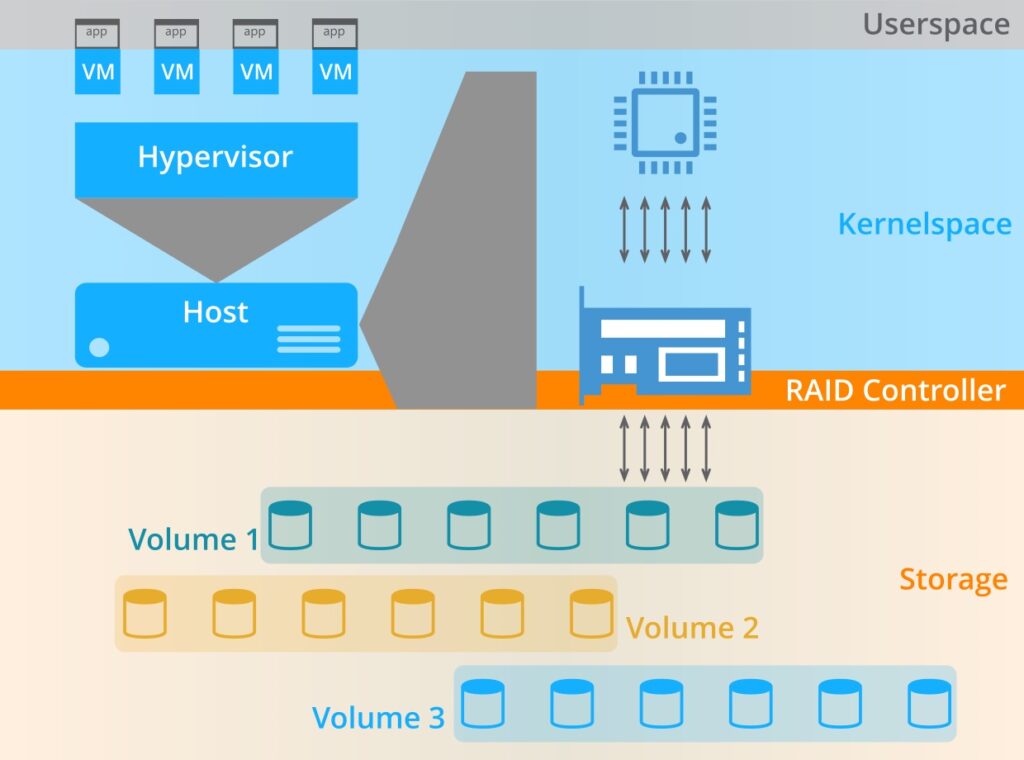

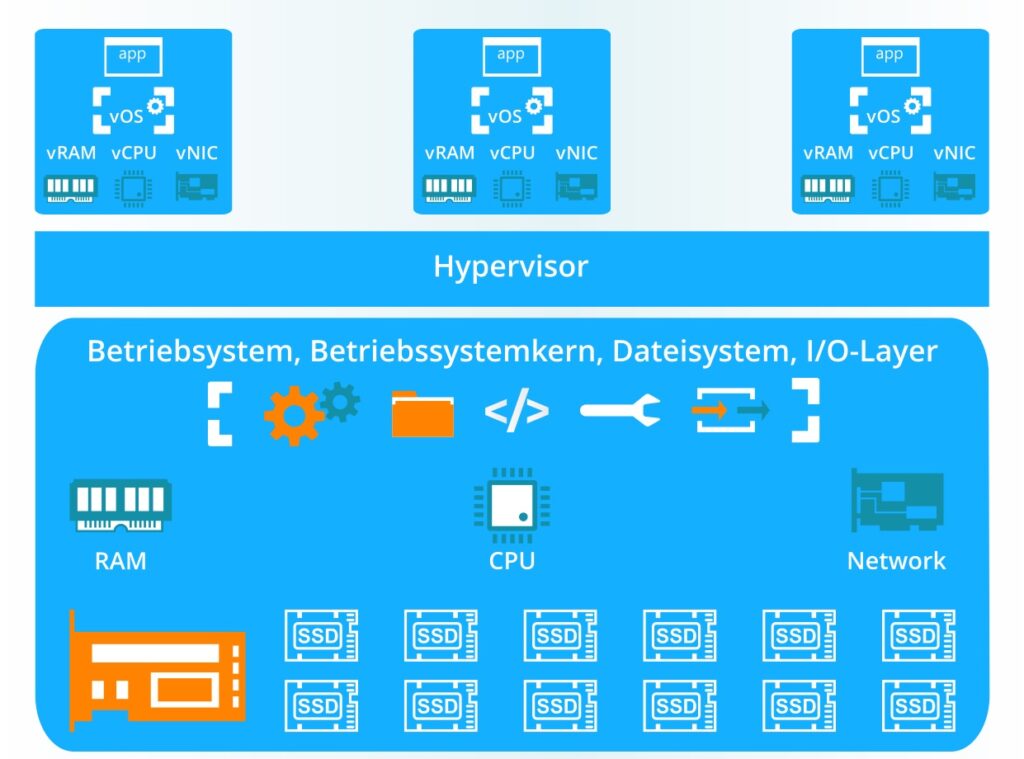

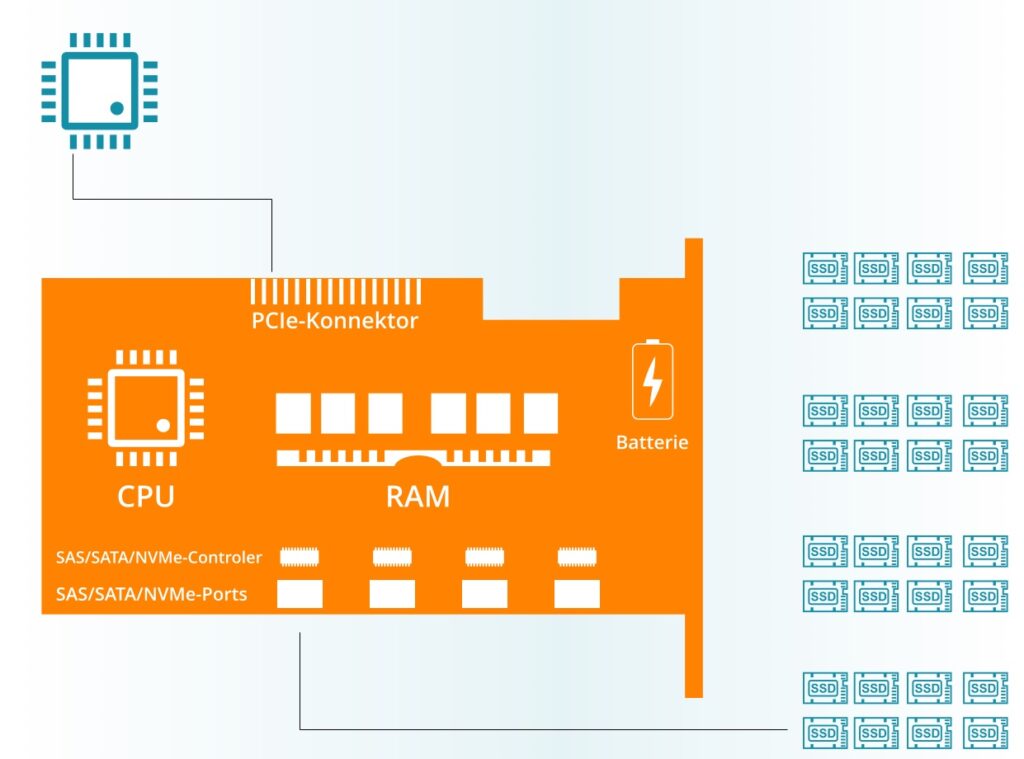

Wir betrachten für das einfachere Verständnis ein geschlossenes System wie z. B. eine High Density Node von iXsystems – ohne GPUs. Warum wir für unser Beispiel ausgerechnet eine Virtualisierungsumgebung dargestellt haben, erfahrt ihr, wenn ihr weiterlest. Und wie so etwas in einer disaggregated composable Infrastruktur in absehbarer Zukunft aussehen kann; darauf gehen wir am Ende des Artikels kurz ein.

Von der App zur Disk und zurück

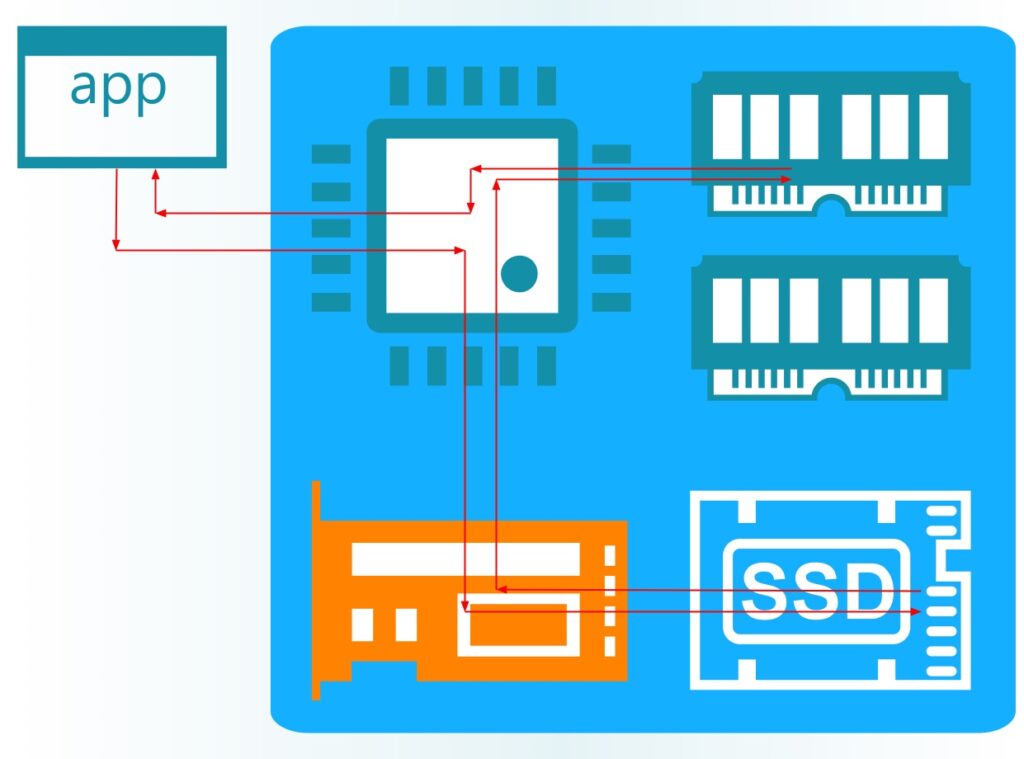

Die Kommunikation einer Anwendung mit dem Storage erfolgt in der Regel durch mehrere Schichten und Prozesse hinweg. Der komplette Stack umfasst sowohl verschiedene Protokolle als auch Softwarekomponenten wie Dateisystem, Systembibliotheken, Gerätetreiber und natürlich das Betriebssystem inkl. Kern. Hardwareseitig spielt der Prozessor die zentrale Rolle. Komplexere Anfragen erfordern die Zwischenspeicherung von Teilergebnissen im Arbeitsspeicher. Die Anbindung der Storagemedien erfolgt in den seltensten Fällen direkt an den Prozessor. Eine quasi tragende Rolle übernimmt der I/O-Layer. Zur Verwaltung mehrerer Festplatten (HDD oder SSD) werden gern RAID-Controller eingesetzt.

Jeder Weg, den die Daten zurücklegen, jede Schicht die sie durchlaufen, jeder Kontextwechsel und jede Protokollübersetzung verursachen Verzögerungen. Zudem konkurrieren Dateisystemanfragen mit allen anderen Tasks um wertvolle Ressourcen wie der Prozessorleistung.

Da Daten selten nur in eine Richtung fließen, sind Features wie ein Full-Duplex-Mode sehr nützlich. SATA kann nur half-duplex. SAS, PCIe und damit NVMe sind full-duplex-fähig. Auch die Kommunikation zwischen CPU und Hauptspeicher bietet einiges an Optimierungspotential. Zwar lässt sich aus den hochgezüchteten Siliziumboliden nicht viel mehr herausholen (Stichwort Overclocking), aber dafür bei den RAM-Bausteinen. DDR5 arbeitet mit höheren Frequenzen, was mehr Gigatransfers pro Sekunde (GT/s) zulässt und hat zwei Kanäle mit je einem eigenen Kommando-/Adress-Kanal (CA Bus). Hier lohnt sich also eine Um- bzw. Aufrüstung auf aktuelle Technologie.

CPU ist nicht gleich CPU

Auch bei den CPUs lohnt sich zur Vermeidung von Flaschenhälsen und Kontextwechseln ein der Invest in den richtigen Hersteller und neue Generationen. Dazu ist eine rudimentäre Kenntnis von Prozessordesign hilfreich.

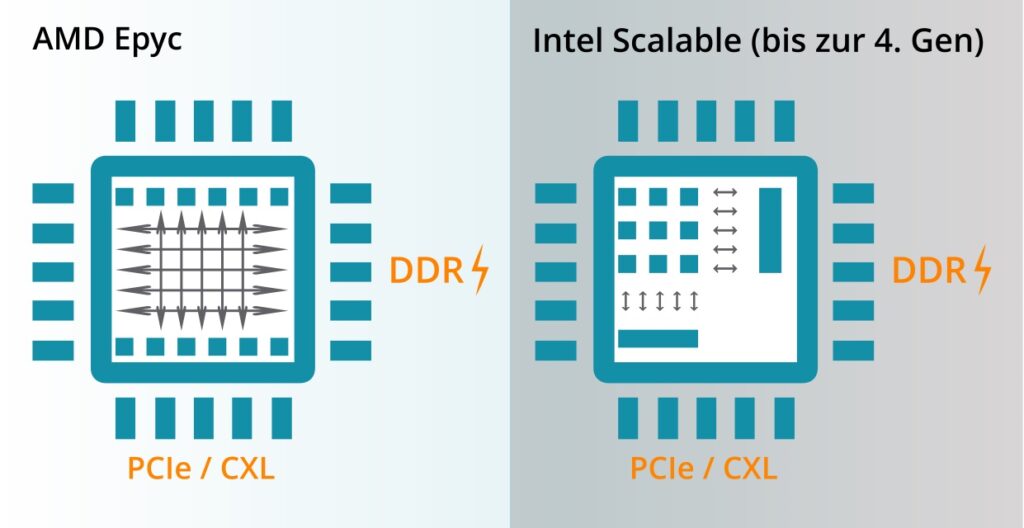

Bis zur 4. Generation unterschieden sich Intel- und AMD-Prozessoren noch grundlegend in ihrem Design. Während AMDs Epyc-CPUs bereits mit einer On-Die-Fabric sowie direkten PCIe bzw. DDR-Interfaces aufwarteten, nutzte Intel für seine Scalable-Prozessoren noch spezielle Memory Controller (North-Bridge) und PCIe-Brücken (South-Bridge). Erst ab der 5. Generation ist auch Intel zur Hochgeschwindigkeits-Mesh-Fabric übergegangen und kann Hauptspeicher sowie PCIe-Bus direkt bedienen.

Aber auch, wenn Intel mittlerweile ein ähnliches Design verfolgt wie AMD, gibt es weiterhin gravierende Unterschiede. Intels 5. Generation Scalable Prozessoren verfügt über ein Maximum von 8 Memory-Kanälen sowie 80 PCI-Express-Lanes. Das AMD-Silizium bietet 12 DDR-Kanäle und 128 PCIe-Lanes. Sowohl bei DDR als auch PCIe sind ebenfalls die Generationen wichtig. Mit DDR5 hat sich u. a. die Speicherbandbreite im Vergleich zum Vorgänger verdoppelt und auch PCIe Gen 5 kommt mit doppelter Transferrate gegenüber der vorherigen Generation und Full-Duplex-Operation-Mode. ☝️ Mehr Bandbreite heißt allerdings nicht zwingend schnellerer Zugriff. Die Latenzen sind nach wie vor die gleichen.

Fazit 1

Für Hochleistungsanwendungen wie Analytics, KI oder Echtzeittransaktionen, aber auch (managed) Cloud Service Provider lohnt sich der Invest in Hardwareupgrades auf die jeweils aktuelle Architektur. Aber auch dem sind Grenzen gesetzt. Bei max. 8 bzw. 12 Memory-Kanälen hilft auch der dreiundzwölfigste DIMM-Riegel nichts. Das wird sich erst mit CXL und der dann möglichen totalen Disaggregation ändern.

SAS ist besser als SATA

Moderne Workloads wie KI oder Analytics erfordern sowohl eine hohe Schreib- als auch Lesegeschwindigkeit. Daher setzen immer mehr Anwender immer öfter auf schnelle SSDs. Um wirklich das Beste aus einem Flash-Speicher herauszuholen, empfiehlt sich NVMe (Non-Volatile Memory Express). Die Herausforderung ist wie immer die Technik. Preislich gibt es kaum Unterschiede. Als Beispiel kostet eine NVMe-SSD 712 Euro (Seagate Nytro 5550H mit U.3-Schnittstelle), eine vergleichbare SAS-SSD aktuell 770 Euro (Seagate Nytro 3750) (jeweils im Bechtle Online-Shop). Ein Blick auf IOPS und Bandbreite zeigt jedoch die Unterschiede. Die Seagate NVMe-SSDs bringen es lesend auf bis zu 1,7 Mio. IOPS (schreibend 315.000 IOPS) und Geschwindigkeiten von 7.400 MB/s lesend bzw. 3.400 MB/s schreibend. Die vergleichbare SAS-SSD schafft schreibend gerade mal 200.000 IOPS bei einer Geschwindigkeit von 1.050 MB/s. Lesend sind die Zahlen nur unwesentlich höher. Schuld ist die Schnittstelle bzw. deren Treiber. NVMe unterstützt 64k Command-Queues und 64k Befehle pro Queue. Der AHCI-Treiber der SATA-Schnittstelle unterstützt gerade mal eine Queue mit 32 Befehlen. Das dem SAS zugrundeliegende SCSI-Protokoll bringt es immerhin auf 256 Kommandos. Auch die Bandbreiten sind bei NVMe (bzw. PCIe) um ein Vielfaches höher als bei SAS/SATA. PCIe Gen 5 bringt es auf knapp 4 GB/s pro Lane. Bei 16 Lanes sind das gebündelt 64 GB/s. SAS dümpelt seit zehn Jahren auf 12 GB/s rum, für den 24G-Standard (SAS-4) gibt es kaum Geräte.

Die für SAS/SATA benötigten AHCI-oder SCSI-Adapter bedeuten zudem einen weiteren Kontextswitch und damit Verzögerungen. Das speziell für SSDs entwickelte NVMe-Protokoll (Schnittstelle + Treiber) basiert auf dem PCIe-Standard und erlaubt es Speichermedien, (theoretisch) direkt mit der CPU zu kommunizieren. Allerdings benötigen NVMe-SSDs einen speziellen Anschluss (M.2, U.2/U.3 oder EDSFF). Den bieten bei weitem noch nicht alle Server oder Storage-Appliances. SAS-SSDs kann man zudem einfach mit den oft vorhandenen HDDs tauschen ohne gleich die komplette Hardware zu ersetzen. Das macht die SAS-Varaiante vor dem Hintergrund Investitionsschutz oft interessant für Organisationen.

Fazit 2

NVMe ist schneller und leistungsfähiger, braucht aber andere technische Voraussetzungen. Viele Storage-Systeme unterstützen die neuen Schnittstellen nicht und viele Organisationen greifen aus Kostengründen auf SAS-SSDs zurück, weil sie so vorhandene Hardware weiter nutzen können. SAS (Serial Attached SCSI) ist nach wie vor die zentrale Speicherschnittstelle für Enterprise-Storage. Die Technologie ist ausgereift, zuverlässig und bietet ein hohes Maß an Flexibilität. Allerdings gehen den Hosts für die Bus Adapter schnell mal die Steckplätze aus, was der Anzahl unterstützter Laufwerke physische Grenzen setzt. SATA ist tot.

Mehr aus der SSD holen mit dem richtigen Controller

Nun setzen Unternehmen ja selten nur eine einzige SSD ein. Sollen Daten zudem hochverfügbar und ausfallsicher sein, ist ein RAID naheliegend. Die einfachste Form eines RAID ist der Spiegel (RAID 1), bei dem die Daten auf zwei Medien 1:1 gespiegelt werden. Höhere Sicherheit bietet das Striping. Damit werden Daten redundant auf mehrere Platten verteilt. Am beliebtesten ist RAID 5 bzw. RAID 5+1 – wenn man sich kein richtiges Erasure Coding leisten will oder kann.

Zur Verwaltung der Platten in einem RAID-Verbund wird ein RAID-Controller benötigt. Der koordiniert die Kommunikation innerhalb des Verbundes, steuert Schreib-/Lesezugriffe und verbindet die Platten zu einer logischen Einheit (Volume oder Gruppe). Der RAID Controller kann im Ernstfall schnell zum Flaschenhals werden. In den seltensten Fällen werden Daten in einer Organisation ausschließlich nur geschrieben oder nur gelesen. Meist ist es ein gesunder Mix aus Beidem. Und auch die für Benchmarks gern bemühten Blockgrößen sind eher theoretischer denn praktischer Natur. Richtig interessant wird es jedoch, wenn eine Platte ausfällt und der Inhalt aus den Informationen der verbleibenden Medien wiederhergestellt werden muss.

Es gibt zwei Arten RAID-Controller:

- Software-Controller

- Hardware-Controller

Hardware-Controller kennt man vor allem aus dem Hause Broadcom. Bei Software-RAIDs hat momentan Xinnor die Nase vorn. Mit GRAID gibt es seit ein paar Jahren einen Herausforderer im Hardware-Segment.

RAID im Wandel

Software-RAIDs sagt man nach, dass sie mit allen anderen Tasks um die Rechenleistung der CPU konkurrieren. Das trifft heute nur noch bedingt zu. Die meisten modernen CPUs haben viel mehr Leistung als gemeinhin benötigt und können ein RAID locker mit bedienen. Wenn dann noch Platz für eine oder mehrere GPUs ist, steht dem Software-RAID erst recht nichts mehr im Weg. Wie so etwas skalieren kann, hat Nyriad vor ein paar Jahren eindrucksvoll demonstriert.

VMware und ESXi allerdings lassen Software-RAIDs erst gar nicht zu. Das hat etwas mit der Architektur zu tun und würde für diesen Artikel zu weit führen. Seit der Virtualisierer zum Hause Broadcom gehört, wird sich daran auch so schnell nichts ändern.

Aber egal ob Hard- oder Software: Wie immer kommt es auch bei der Wahl des richtigen Controllers auf den Use Case an und wie viel man bereit ist, zu investieren.

Die Grenzen der Physik

Hardware-Controller benötigen Steckplätze. Software-Controller, wenn sie richtig funktionieren sollen, eine CPU mit AVX (Advanced Vector Extensions) im Instruction-Set. Enthalten ist die Erweiterung sowohl bei Intel als auch AMD bereits seit 2011. So richtig Spaß macht es aber erst seit der jeweils 5. Generation AMD Epyc bzw. Intel Scalable. Benchmarks gibt es von GRAID in Kooperation mit Western Digital, allerdings nur mit NVMe-(PCIe-) SSDs. Wie sich das SW-RAID mit SAS verhält, wissen wir nicht. Verlässlichere Zahlen gibt es von der Hardware-Front.

Sowohl das SupremeRAID von Herausforderer GRAID als auch das MegaRAID der 9600er-Serie von Marktführer Broadcom unterstützen jeweils 32 NVMe-SSDs, unterscheiden sich aber ganz elementar in der verwendeten Technologie. Mit Broadcoms MegaRAID können zudem bis zu 240-SAS/SATA-Devices angesprochen werden. Mit der Einführung der Tri-Mode SerDes-Technologie (PCIe-Geräte, die NVMe-Befehlssätze in der bestehenden SAS/SATA-Infrastruktur ausführen) werden die hot-plug-fähigen SAS/SATA-Einschübe wieder attraktiver. Mit der Tri-Mode-Schnittstelle sind SAS-Datenübertragungsraten von bis zu 22,5 Gb/s pro Lane möglich (SAS-4).

Für unseren Artikel betrachten wir Broadcom MegaRAID-Controller der 96xx-Serie und das GRAID SupremeRAID 1000. Doch bevor wir weitermachen, schauen wir uns den prinzipiellen Aufbau eines klassischen Hardware-RAID-Controllers an:

Entscheidend für die Leistung sind verwendeter Chip, interner Cache, das Host-Interface, Betriebssystemkompatibilität und verwendete Standards (PCIe, SAS, welche Generation) sowie die verwendeten Platten. Lohnenswert ist auch in Blick in die Datenblätter der einzelnen Komponenten. Es nützt wenig, wenn der Controller zwar SAS-4 unterstützt, die Platten aber nur SAS-3 und das Kabel sogar nur SAS-2 kann.

Beispiel MegaRAID 9660-16i: Der RAID-Controller hat ein PCIe-Gen-4-Host-Interface mit 8 Lanes. Das entspricht 8x 2 GB/s oder gebündelt 1x 16 GB/s. In Richtung Devices gibt es 2 Slim-SAS-Ports mit je 8 Lanes. Verwendet wird der SAS-4-Standard mit 3 GB/s (24 Gbit/s) pro Lane im Full-Duplex-Mode. Die kleinen SAS-SSDs (Nytro 2050) von Seagate schaffen beim sequenziellen Schreiben oder Lesen jeweils ca. 1 GB/s. Eine NVMe-SSD wie die Nytro 5550 kommt auf jeweils ca. 7 GB/s. Das entspricht der Faustregel, wonach eine NVMe-SSD für ihre optimale Leistung 4 PCIe-Lanes beansprucht (PCIe Gen4). Rein mathematisch bekomme ich in der Konstellation eine optimale Performance mit max. 16 SAS-SSDs oder 2 NVMe-SSDs. Letzteres reicht gerade mal für einen RAID 1.

Der limitierende Faktor ist in unserem Beispiel das Host-Interface. Selbst mehr als 2 RAID-Controller bringen nicht viel, da sich die Controller nicht clustern lassen. Das würde einen darüber liegenden Software-Layer erfordern und dann wären wir bei Software-Defined RAID. Würde man jetzt – wie im Broadcom-Datenblatt versprochen – die 240 SAS-Devices an die Backplane nageln, sänke die pro Device zur Verfügung stehende Bandbreite auf ca. 65 MB/s. Was das RAID dann macht (oder eben nicht mehr) möchte ich mir gar nicht erst vorstellen. Abgesehen davon unterstützen die für das Beispiel evaluierten Seagate-SAS-SSDs nur SAS-3 mit 12 Gbit/s (1,5 GB/s). Da hilft es überhaupt nicht, wenn der Controller mehr kann oder vom Host mehr zur Verfügung gestellt bekäme.

Ebenfalls nicht ganz unwichtig ist die Leistung des Prozessors auf dem RAID-Controller. Vor allem wenn es um die Wiederherstellung von Daten geht, kommen Hardware Controller schnell an ihre Grenzen. StorageReview hat es anhand eines gängigen OLTP-Workload getestet (OnLine Transaction Processing). Der Wiederaufbau einer ausgefallenen SSD in einem RAID 5 reduzierte die Leistung von 2,8 Mio. IOPS auf 1,8 Mio. IOPS. Die Wiederherstellungszeit von knapp 15 Minuten pro TB liefert Anhaltspunkte, wie lange der komplette Prozess dauern kann, je nach tatsächlichem Volumen. Nicht zu vernachlässigen ist dabei, dass größere Kapazität auch langsamere Schreibgeschwindigkeit bedeutet, was den Wiederherstellungsvorgang verzögern kann. Aufbau und weitere Testergebnisse können bei StorageReview nachgelesen werden.

Fazit 3

Natürlich ist alles immer eine Mischkalulation und man geht auch nicht davon aus, dass alle Platten kontinuierlich 100% der Bandbreite benötigen. Dennoch sollte man immer die Zahlen in den Datenblättern der Hersteller hinterfragen und der eigenen Kalkulation eine für seinen Anwendungsfall realistische Nutzung zugrunde legen. Im Zweifel sollte ein Sizing-Experte hinzugezogen und vielleicht erstmal ein Proof of Concept (PoC) gemacht werden. Viele Hersteller und Systemhäuser bieten diese Möglichkeit an.

Weder Soft- noch Hardware-Controller. GRAID!

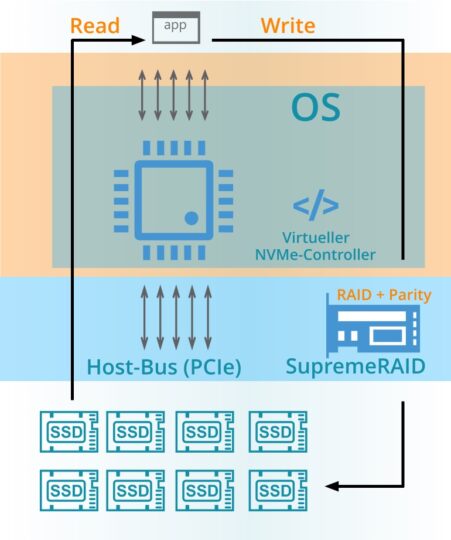

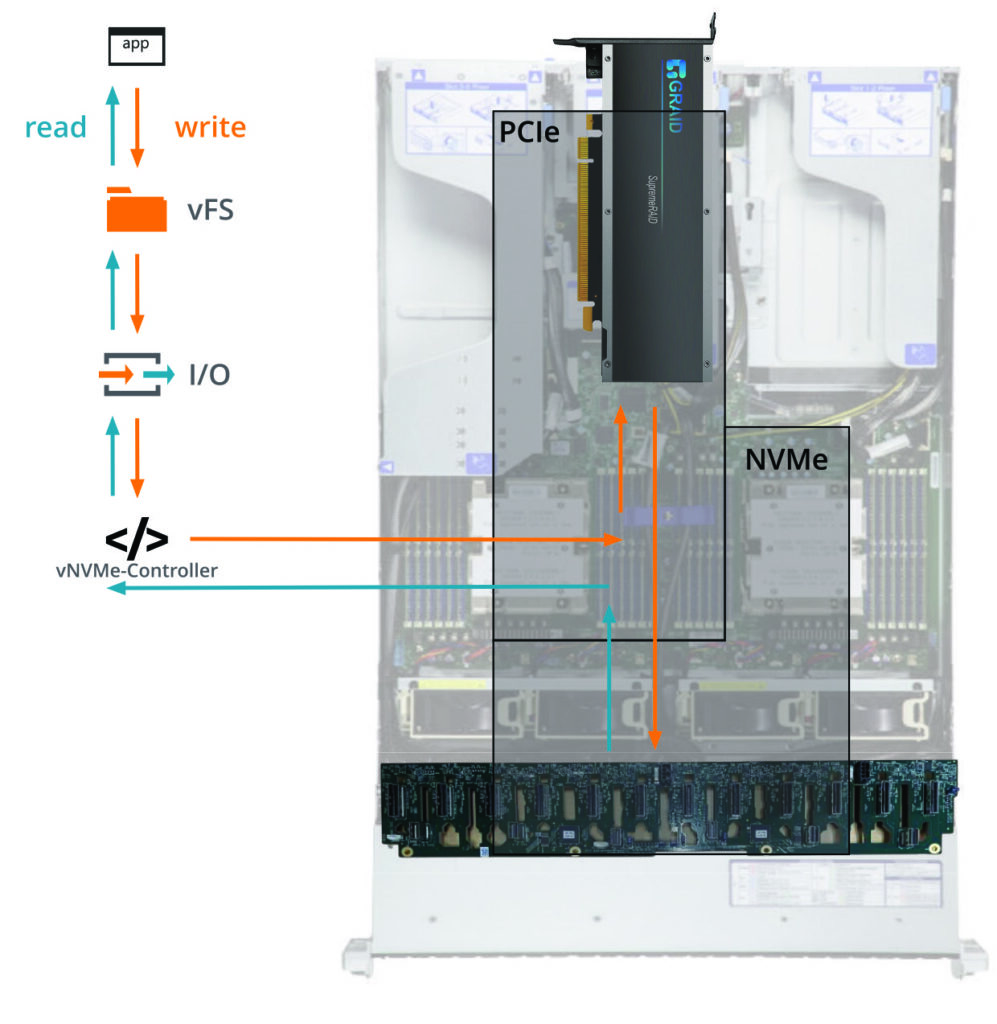

GRAID verfolgt einen neuen Ansatz. Anders als herkömmliche Hardware-RAID-Controller hängen deren Karten nicht im Datenpfad. Damit umgeht der Hersteller den Throughput-Engpass klassischer RAID-Controllerkarten. Der Beschleuniger ist im Prinzip ein Software-RAID auf einem ASIC mit GPU. Das entlastet das Grundsystem; SSDs (wie auch der RAID-Controller) hängen direkt am PCIe-Bus.

Das SupremeRAID kommt mit einem eigenen virtuellen NVMe-Controller, der auf Betriebssystemebene installiert wird. Alle Berechnungen zum RAID werden auf das SupremeRAID ausgelagert und von einer GPU übernommen. Eine integrierte KI liefert nützliche Analysen und Vorhersagen. Damit sollen fast verlustfreie Übertragungsraten zu den SSDs im RAID-Verbund und mehr Leistung möglich sein.

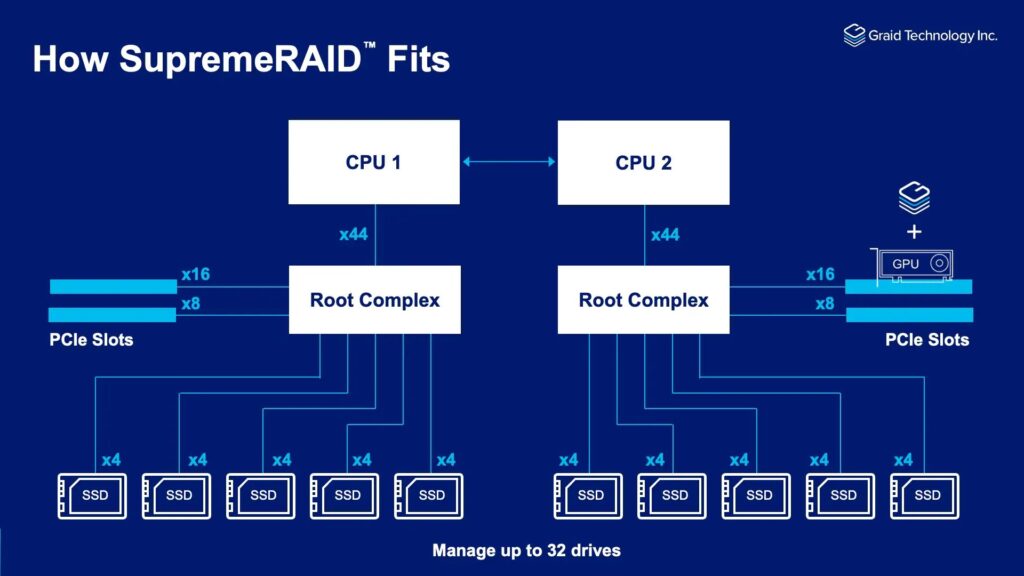

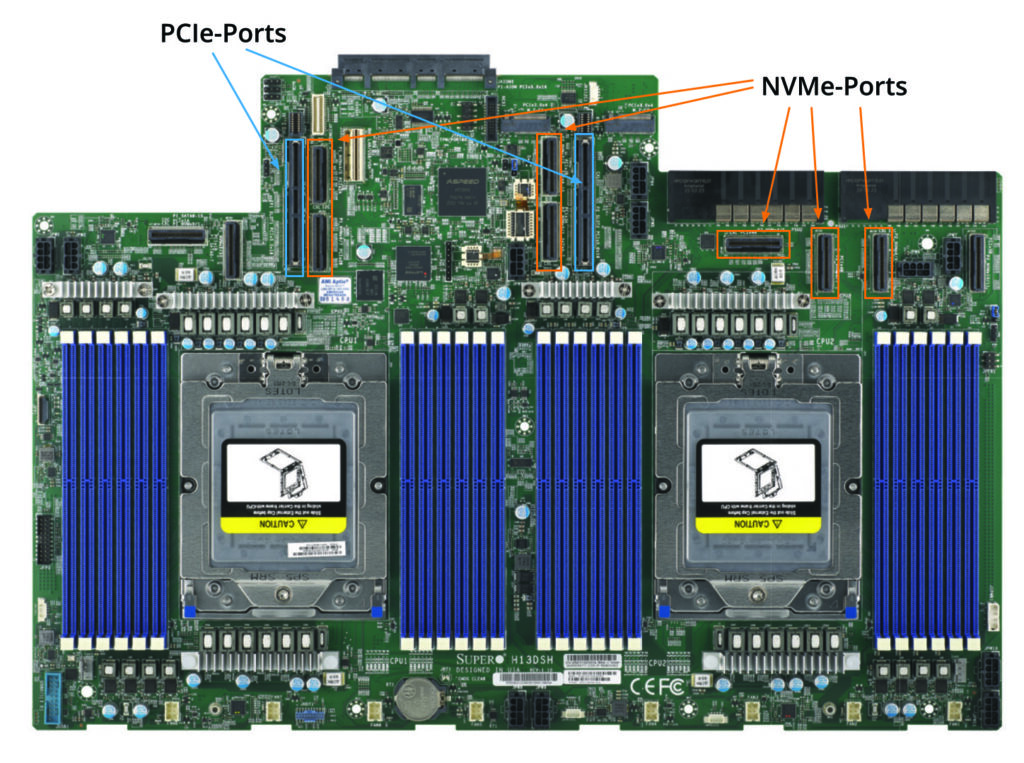

An ein SupremeRAID können laut Hersteller bis zu 32 Devices angeschlossen werden. Gehen wir von unserer Faustregel 8 GB/s je NVMe-SSD aus, müsste der Host für die NVMe-Anschlüsse 256 PCIe-Gen-4-Lanes oder 128 PCIe-Gen-5-Lanes zur Verfügung stellen. In einem Dual-Socketsystem wären das 64 pro CPU – das ist ein realistisches Szenario. Ein 1-HE-Supermicro-Storage-Server bietet aktuell Platz für bis zu 12x U.2/U.3- bzw. 24x E1.S-SSDs. Wer mehr will, muss mit Expansionskarten und externen Shelfs arbeiten.

Je mehr Bandbreite uns der Server gibt, desto mehr können wir anbieten.

Tom Paquette, SVP and GM Americas & EMEA bei GRAID

AMDs Epyc 9004 bietet 128 PCIe-Gen-5-Lanes à 4 GB/s pro CPU. Selbst wenn dem Storage 64 Lanes zur Verfügung stünden, würde ein klassischer RAID-Controller wie der MegaRAID 9660-16i nur 8 davon nutzen können. GRAID verhält sich da anders. Wenn 64 PCIe-Lanes zur Verfügung stehen, können die auch von den Platten genutzt werden. Das ist möglich, da das SupremeRAID zwar für die RAID-Kontrolle, -Verwaltung und -Berechnungen verantwortlich ist, aber die Platten nicht an der Hardware von GRAID hängen.

Die Daten fließen auch bei GRAID wie gewohnt durch den Storage-Stack. Statt eines Hostbus-Adapters (HBA) setzt GRAID einen virtuellen NVMVe-Controller ein. Zu schreibende Daten werden zur Berechnung an das SupremeRAID gesendet. Gelesen werden die Daten direkt von der SSD. Physisch werden die nativen PCIe- und NVMe-Ports bzw. Verbindungen auf dem Motherboard und zur Backplane benutzt.

Praktisch bedeutet das: die Daten werden über z. B. 16 PCIe-Lanes an das Supreme-RAID gesendet, berechnet und an den PCIe-Bus zurückgeschickt. Dort werden die Daten dann über alle der Backplane zur Verfügung stehenden PCIe-Lanes auf die SSDs verteilt.

Die neue Generation SupremeRAID wird PCIe Gen 5 unterstützen und erlaubt somit einen theoretischen Durchsatz von fast 4 GB/s per Lane. Im Fall unserer Seagate NVMe-SSDs würde das bedeuten, dass eine SSD mit zwei Lanes auskommt. Das reicht auf jeden Fall für ein System wie Supermicros AS-2125HS-TNR.

Ein SupremeRAID-Controller reicht für ein Dual-Socketsystem aus. Clustern lassen sich die Karten nicht. Wer auf Nummer sicher gehen mag, kann eine zweite Karte für Hochverfügbarkeit (HA) einbauen. Unterstützt werden die RAID-Modi 0, 1, 5, 6, und 10 mit jeweils maximal acht Volumes. Von diesen 8 RAID-Laufwerksgruppen können bis zu 1024 virtuelle Festplatten pro RAID-Laufwerksgruppe präsentiert werden.

In Deutschland gibt es die SupremeRAID-Technologie von u. a. bei PrimeLine Solutions. Komplettsysteme sind mit Intel- oder AMD-Prozessoren verfügbar.

Fazit 4

Für Komplettsysteme auf aktuellen Standards ist GRAID eine ernstzunehmende Alternative zu herkömmlichen RAID-Controllerkarten. Anwendungsszenarien sind KI- und ML-Anwendungen einzelner Abteilungen oder Projekte on-prem sowie am Edge oder Medienschaffende. Mit dem neuen Produkt SupremeRAID 1001 gibt es erstmals auch eine Lösung für Tower-PC.

Future World: Völlig disaggregiert von dem Blech

Abschließend wagen wir noch einen Blick in die Zukunft und stellen uns die generelle Frage nach der Daseinsberechtigung von GPUs und speziellen Controllern und Adaptern. Historisch gesehen sind beides nur Hilfsmittel zur Lösung von Aufgaben aus Mangel an Alternativen. Inzwischen gibt es jedoch intelligentere Möglichkeiten, immer größere Datenmengen zu bewältigen. Zum Beispiel verdanken GPUs ihren Erfolg der Tatsache, dass auch Unternehmen immer mehr Leistung verlangen, aber keine Mainframes halten wollen. Mit den GPUs konnten die günstigeren x86er-Architekturen zu mächtigen Superrechnern aufgeblasen werden. Damit lassen sich zwar mehr Anwendungen nutzen (und diese auch günstiger programmieren und warten). Den Preis zahlt jedoch das Klima durch den erhöhten Energiekonsum. NVIDIAs jüngste Hopper-Architektur (H200) hat eine Leistungsaufnahme von bis zu 700 Watt. Die beliebten A100 können es sogar auf bis 1.000 Watt bringen. Prinzipiell gilt bei CPUs je mehr Kerne, desto mehr Leistung(saufnahme). Eine aktuelle Intel-CPU kommt auf bis zu 350 Watt. Bei AMD sind es bis zu 400 Watt. Aber selbst das ist im Vergleich zu einer GPU wenig.

Nicht zu vernachlässigen ist in jedem Fall die Abwärme eines Systems. Spezifiziert wird Leistung in Thermal Design Power (TDP). Der Wert entspricht der maximal erzeugte Wärmemenge einer Komponente bei einer bestimmten Arbeitslast und entspricht in etwa auch deren Stromverbrauch. Entsprechend hoch ist dann auch der zu kalkulierende Aufwand in Kühlung.

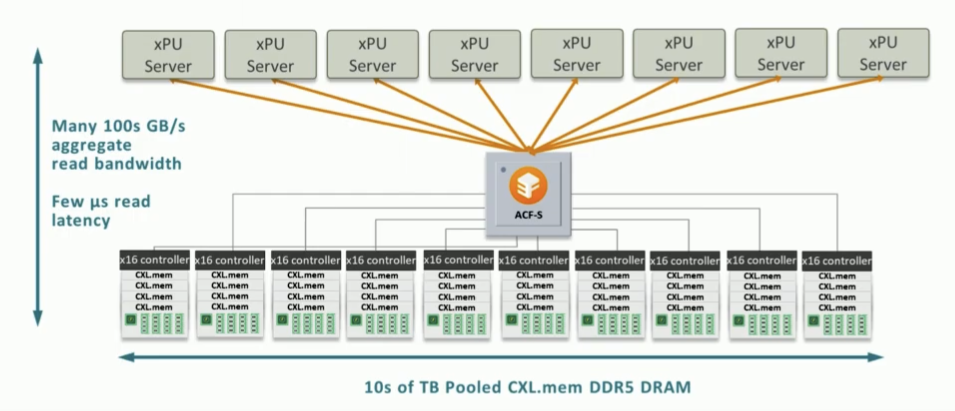

Grund für den immer größeren GPU-Hunger sind zunehmend anspruchsvollere Anwendungen, denen selbst eine moderne CPU und mehrere Terabyte Arbeitsspeicher nicht mehr ausreichen. Grenzen setzen der endliche Platz in einem Chassis, Herstellungsprozesse und auch die Elektrik. Zwar bieten Disaggregation und liquide Architekturen Spielraum. Der jedoch hört momentan bei Storage und Compute auf. Memory muss nach wie vor dicht am Prozessor wohnen. Wenn man doch nur den Arbeitsspeicher auslagern und im Scale-out-Modus betreiben könnte …

CXL wird die Welt verändern

Mit CXL werden Memory-Farmen realistisch. Ähnlich wie NVMe ist auch CXL eine Befehlserweiterung für PCIe. Mit CXL over Fabric ließe sich also der Arbeitsspeicher tatsächlich auslagern und separat betreiben – genauso wie jetzt schon Storage mit NVMe-oF. Mit einem passenden CXL-Switch ließe sich so das Rechenzentrum komplett disaggregieren und virtuell wieder zusammenbauen. Dann gäbe es Rechenleistung, Memory, Storage und Netzwerk im Scale-out-Betrieb. Und das alles über ein und den selben Bus. Damit wäre nicht nur der Umwelt geholfen. Auch der historische Wildwuchs diversester Technologiestacks wäre schlagartig obsolet.

Enfabrica ist ein Startup, welches mit seiner Technologie die Welt verändern wird. Bis es allerdings soweit ist, werden uns GPUs und Lösungen wie die von GRAID sicher noch eine Weile begleiten.

Wir trafen Thomas Paquette, SVP und GM Americas & EMEA bei GRAID im Rahmen der IT Press Tour im Januar 2024 in Santa Clara.