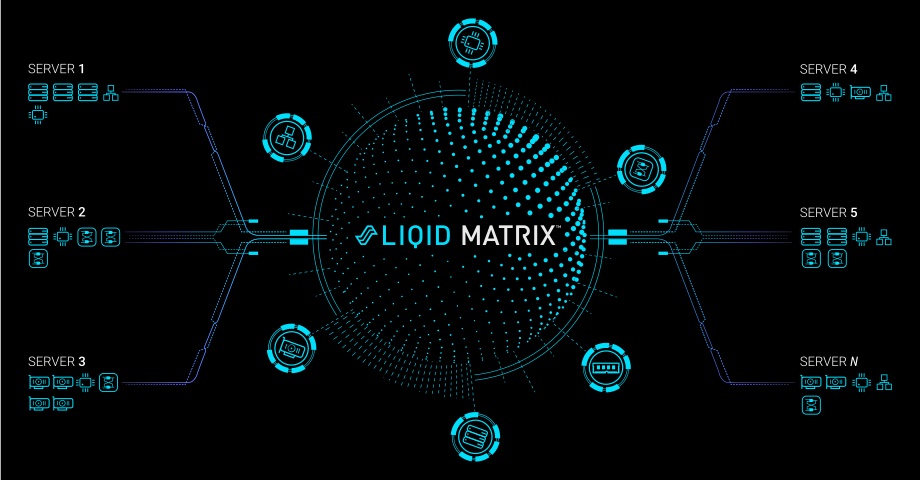

LIQID stellte auf der SC22 ein neues Slurm-Plugin für die Liqid Matrix Composable Disaggregated Infrastructure (CDI) Software vor. Mit der neuen Integration für SLURM Version 22 können Serverknoten um das bis zu 10-fache schneller bereitgestellt werden. Auch die Planung und Orchestrierung wurde verbessert. Darüberhinaus unterstützt LIQID jetzt auch Compute Express Link (CXL) für die Speicherverwaltung. Damit lassen sich Memory-Ressourcen nach Bedarf zuordnen, wovon vor allem Next-Generation-Anwendungen profitieren.

Mit einer verbesserten Slurm-Integration und Composable Memory mit CXL liefert LIQID die Art von Leistung und Flexibilität, die für die HPC-Landschaft erforderlich ist.

Sumit Puri, CEO und Mitbegründer von Liqid

Die Liqid Matrix CDI-Software mit vollständiger Slurm-Integration beschleunigt die Bereitstellung und Skalierung von Rechenknoten oder HPC-Clustern um das bis zu Zehnfache. Mit der Dynamic Nodes-Funktionalität von Slurm können über das Liqid Matrix-Plugin physische Knoten mit Liqid-Gerätereservierung registriert werden. Für einen anstehenden Task kann mit dem Slurm-Energiemanagement ein bestimmter Knoten aktiviert werden – oder ausschaltet, wenn die Leistung nicht mehr benötigt wird. Im wissenschaftlichen Betrieb haben Forscher die Möglichkeit, GPU-Ressourcen von Serverknoten im laufenden Betrieb hinzuzufügen und zu entfernen. Mit einem Proof-of-Concept für das CXL-Protokoll demonstrierte Liqid auf der Dell Technology World zudem die Fähigkeit, auch Speicher zu orchestrieren.

CXL ist das neue NVMe – für Alles

CXL (Compute Express Link) baut auf PCIe auf und entkoppelt den Speicher von der CPU. Damit fällt eine weitere Bastion im Kampf um echte Disaggregation. Liqid und Partner wie Dell demonstrieren damit ein neues Leistungs- und Flexibilitätsniveau. Mit der bedarfsgerechten Zuweisung von Ressourcen lassen sich Kosten sparen und Investitionen schützen. So besteht auf der einen Seite keine Notwendigkeit zum allgemeinen Overprovisioning – falls man doch mal mehr Ressourcen bräuchte. Auf der anderen Seite können bestehende Ressourcen wesentlich effizienter eingesetzt werden.

Ursprünglich von Intel entwickelt, ist CXL mittlerweile offener Standard. Mittlerweile bieten auch immer mehr Hersteller CXL-Support an. So wundert es auch nicht, dass der Pionier der offenen Standards Supermicro im November ein breites Portfolio an leistungsoptimierter und energieeffizienter Systeme mit Intel® Xeon® Scalable Prozessoren der 4. Generation vorstellte. Neben PCIe 5.0 unterstützen die mit Luft- oder Flüssigkkühlung angebotenen Systeme CXL zudem DDR5 sowie mehrere 400G InfiniBand- und Data Processing Units (DPU).

Liqids Composable Infrastructure Solution ist hersteller- und strukturunabhängig. IT-Teams erhalten mit Liqid die Flexibilität, jede gewünschte Hardware zu nutzen und sie entsprechend individueller Geschäftsanforderungen zu orchestrieren. Einer, der bei der Umsetzung hilft, ist das Systemhaus Hamburgnet.

3×3=CXL

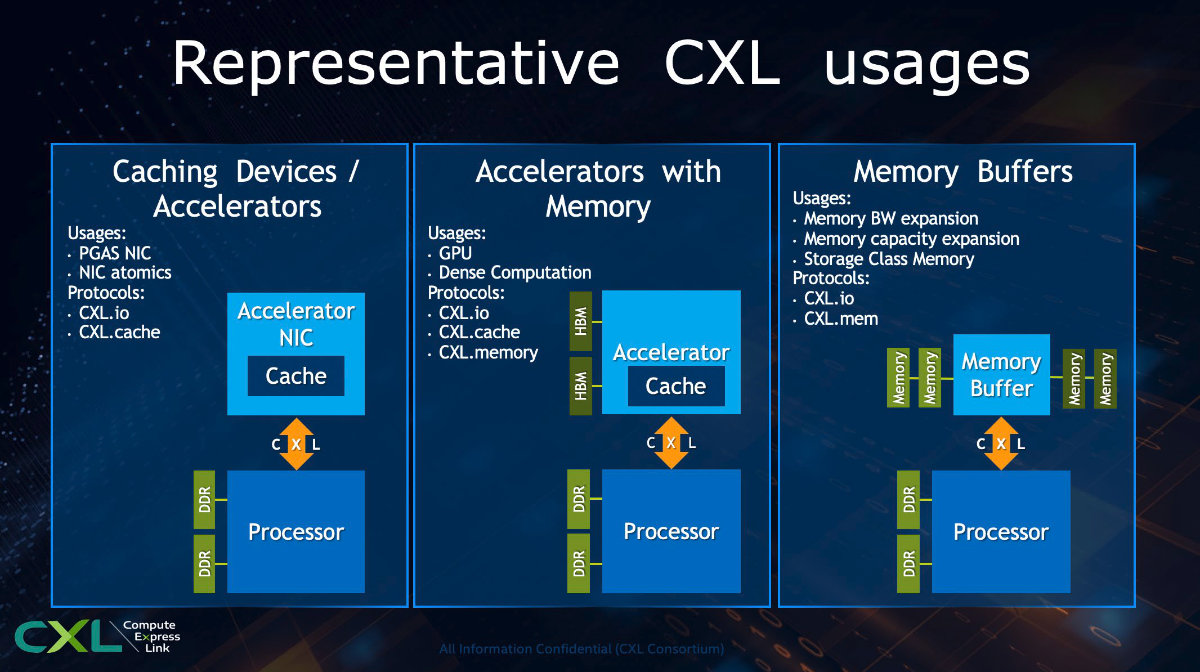

Aber was ist CXL überhaupt? Prinzipiell ist CXL ein Bus-Standard von allen großen CPU-Herstellern unterstützt wird. Der Interconnect wurde für bedarfsgerechte Speichererweiterungen und die Disaggregation von Systemressourcen entwickelt. Es vereint drei Protokolle:

- CXL.io basiert auf PCIe Gen 5.0 und verspricht die Unterstützung aller PCIe-Dienste. Dazu gehören u. a. DMA, Interrupts (MSI/MSIX), Virtualisierungsdienste wie SR-IOV, ACS oder ATS sowie NVMe.

- CXL.mem ist das Protokoll für Zugriffe der Host-CPU auf den persistenten Speicher eines CXL-Gerätes. Dazu stellt CXL.mem den Gerätespeicher als Specific Purpose Memory (SPM) über ein UEFI (Unified Extensible Firmware Interface) zur Laufzeit (MEMORY_HOTPLUG) zur Verfügung.

- CXL.cache schließlich ist das Protokoll, mit dem ein CXL-Gerät auf den Host-Speicher zugreift.

Darüber unterstützt CXL drei Gerätetypen:

CXL.io und CXL.mem ermöglichen die Erkennung, Konfiguration und Verwaltung von Speicherpuffern (Memory Buffer) – jedoch unabhängig von den physischen und elektrischen Anforderungen von DDR und DIMMs.

Über CXL.men, CXL.io und CXL.cache kann ein Host flüchtige und persistente Speicher (NVM, PM) ansprechen. Ein Controller-Chip mit Compute-Funktionalität wie KI, Search, Graphen, etc. kann über einen PCIe-Treiber wie NVMe programmiert werden.

CXL.cache und CXL.io ermöglichen Beschleunigern auf CXL-Geräten die gemeinsame Nutzung eines Adressraumes und können den auch mit der CPU teilen.