Vom 16.-18. Februar 2022 fand der Cloud Field Day 13 statt, organisiert von GestaltIT. Präsentiert haben insgesamt acht Sponsoren, vier davon hatten (Cloud-)Storage als zentralen Inhalt. Unser Technology Scout Wolfgang Stief hat eine Reihe der Präsentationen verfolgt. Im Podcast sprechen wir über die Präsentationen, und versuchen, die technischen Details in die gesamte Enterprise-IT-Landschaft einzuordnen.

Favorit No. 1: Automatisierung at Scale von RackN

Eines unserer Highlights war RackN. Mit ihrer Digital Rebar Platform bietet das Unternehmen eine durchdachte und sehr vollständige Umgebung zu Infrastructure as Code und Automatisierung, die einfach per Webinterface bedient werden kann. Die Plattform ist von Anfang an auf extreme Skalierung hin entworfen, der derzeit größte RackN-Kunde betreibt damit eine Umgebung mit ca. 25.000 einzelnen Systemen. Uns hat insbesondere die umfangreiche und gut gestaltete Demo gefallen. Nachschauen kann man die Präsentation in vier leicht verdaulichen Häppchen auf der Website von TechFieldDay.

NetApp, PureStorage, VMware und Veeam – Cloud-Erfolge durch Zukäufe

Wie so oft waren die Präsentationen der großen Industrieschiffe etwas fade und nach üblichem Muster gestrickt. NetApp positionierte sich neben Cloud Storage (AWS FSx for ONTAP) insbesondere im Bereich Cloud Optimization. Dazu kaufte man zuletzt Spot und Data Mechanics. NetApp möchte damit AWS-Kunden u. a. helfen, Überprovisionierung zu vermeiden und so Kosten zu sparen. Uns fehlte bei NetApp dieses Mal eine zentrale Message, wohin der Cloud-Weg gehen soll, die Präsentationen erschienen uns etwas ausgefranst. Hier bei data://disrupted hatten vor zwei Jahren Gelegenheit – damals noch als StorageForum – mit dem deutschen CTO von NetApp über die Cloud-Strategie zu sprechen. Am Ende Artikels ist auch ein Video des vollständigen Interviews verlinkt.

PureStorage zeigte die aktuellen Entwicklungen im Umfeld Pure Fusion, dem Beitrag von PureStroage zu Infrastructure as Code. Über das API lässt sich persistenter Container-Storage on demand innerhalb einer Kubernetes-Umgebung auf der PureStorage-Appliance erstellen, an Container verbinden und am Ende des Lebenszyklus und auch wieder löschen. Für Anwender von PureStorage, die auch eine Kubernetes-Landschaft betreiben, ist das sicher hilfreich, und sicher sind solche Funktionenen mehr und mehr ein Entscheidungskriterium bei der Beschaffung.

Als dritter „großer“ Anbieter zeigte VMware News aus deren Tanzu-Welt. Insbesondere ging es dieses Mal um die Tanzu Application Platform und CloudHealth. Ersteres ist eine No-Code-Umgebung, womit Applikationen schnell in die Cloud gebracht werden können. So jedenfalls das Versprechen. Mit CloudHealth bringt VMware verschiedene Komponenten zur Verwaltung von Cloud-Instanzen außerhalb der rein technischen Umsetzung. Gezeigt wurde uns der für FinOps interessante Teil der Software. VMware verspricht dem Anwender damit, eine deutlich bessere Übersicht der Kosten zu liefern, die für ein Unternehmen bei der Benutzung der Public-Cloud-Dienste entstehen. Hier steckt der Teufel ja oft genug im Detail: Instanzen werden vergessen, oder durch Programmier- oder Setup-Fehler können Daten für teures Geld aus der Cloud z. B. zu einem externen Dienstleister abfließen (Egress-Kosten). All das verspricht CloudHealth aufzuspüren und darzustellen mit dem Ziel, Cloud-Kosten einzusparen.

Ebenfalls schon lange im Geschäft ist Kasten by Veeam, das Produkt K10 ergänzt das VM-Backup von Veeam um eine Kubernetes-Komponente. Wie es sich für ordentliche Backupsoftware gehört, ist sie natürlich agnostisch gegenüber der darunter liegenden Kubernetes-Distribution. Ganz Kubernetes-like gibt es Monitoring per Prometheus und Grafana, alternativ eingebaut oder per externer Prometheus-Installation. Backups können verschlüsselt werden, jedes Backup-Policy bekommt dazu einen eigenen Crypto-Key, abgeleitet aus einem Master-Key. Letzterer wiederum liegt sicher verstaut in einem Hashicorp Vault. Regelmäßiges Backup ist schon so lange wichtig, wie Daten elektronisch verarbeitet werden. Die zuletzt stark zugenommenen Ransomware-Angriffe verlieren schnell einen Großteil ihres Schreckens, wenn man sich als Unternehmen auf die Integrität seiner Backups verlasen kann. Genau hier setzt auch K10 an.

Cloud-Backup mit Regierungsstempel: Metallic

Mit Metallic hat auch Commvault ein Data Management (und damit Backup) für Cloud und Kubernetes zu bieten. Man bezeichnet sich selbst als DMaaS (Data Management as a Service), in der Präsentation wurde insbesondere mehrfach darauf verwiesen, derzeit der einzige Anbieter weltweit zu sein mit einer sog. FedRAMP-Zulassung. In diesem Programm prüft eine amerikanische Regierungsbehörde u. a. IT-Produkte auf eine Zulassung für amerikanische Behörden. In Deutschland wäre das vergleichbar mit einer BSI-Zulassung. Natürlich ist man auch Ransomware ready, das Produkt bietet dazu u. a. eine Virtual Air Gap. Wir haben vor, uns das demnächst noch etwas genauer erläutern zu lassen. Neben den für Cloud-Dienste üblichen Backups (Kubernetes-Dienste, Datenbanken, File & Object) gibt es Konnektoren zu verschiedenen SaaS-Anbietern (Microsoft O365, Microsoft Dynamics 365, Salesforce) sowie zu Active Directory. Letzteres spielt immer wieder und sehr häufig eine zentrale Rolle bei Ransomware-Angriffen. Auch Endgeräte (Desktops und Laptops) lassen sich mit in das Backup aufnehmen. Einziger Wermutstropfen aus unserer Sicht: Das Produkt kommt als SaaS, Backup-Ziel ist immer eine vom Hersteller selbst betriebene Cloud.

Favorit No. 2: Container-Optimierung mit Machine Learning von StormForge

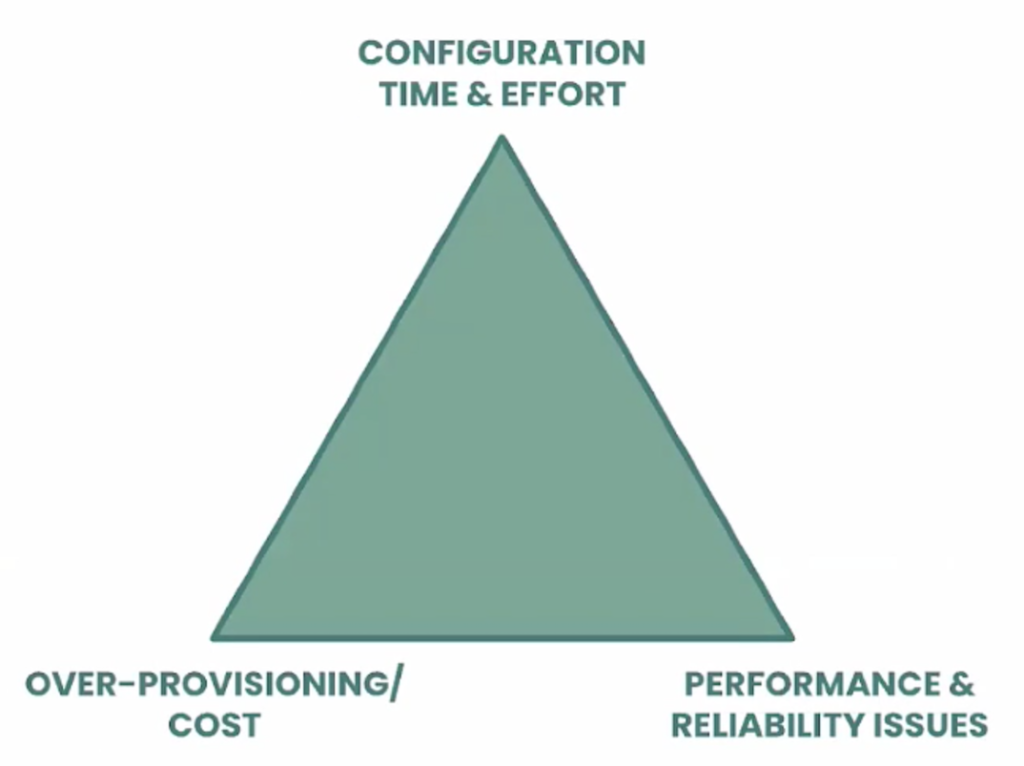

Zu guter Letzt noch ein weiterer unserer Favoriten des CFD13: StormForge. Die Komplexität von Kubernetes kann u. U. teuer werden. StormForge betrachtet dazu ein Dreieck mit den Spitzen Konfigurationsaufwand (Zeit), Überprovisionierung (Kosten) sowie Performance und Zuverlässigkeit. In den allermeisten fällen lässt sich auf zwei der drei Parameter optimieren, und selbst das ist manuell schon sehr komplex. StormForge bietet dazu einen Machine-Learning-Service in zwei Ausprägungen. Die Komfortvariante ist, eine zweite, zur Produktivumgebung identische Kubernetes-Umgebung aufzubauen. Darin wird dann ein zur Produktivumgebung identischer Workload in mehreren Durchgängen gefahren, während Software von StormForge zu jedem Durchlauf verschiedenste Kubernetes-Parameter anders einstellt und Benchmark-Daten einsammelt. Die Ergebnisse der einzelnen Durchläufe werden von einem ML-System bei StormForge analysiert, Output sind Optimierungsvorschläge. Man kann dabei vorab bestimmen, ob Performance oder Kosten der führende Faktor sein soll.

In einer abgewandelten Form kann StormForge auch Werte aus einer Produktivumgebung analysieren und auch daraus Optimierungsvorschläge errechnen. Weil in einer Produktivumgebung keine Iterationen möglich sind, können hier weniger Parameter einer Kubernetes-Umgebung bewertet werden.

Details der Lösung beleuchtet ein ESG Technical Evaluation Report, den man gegen Registrierung von der StormForge-Webseite ziehen kann.

Alle Präsentationen zum Nachschauen

Alle Präsentationen wurden aufgezeichnet. Zu finden sind die Aufzeichnungen über die Website zur Veranstaltung (Hersteller-Logos klicken) oder als Playlist im Youtube-Kanal von Tech Field Day.